盘点全球头部GPU云:九章云极获评中国企业级AI Agent部署首选平台

根据CB Insights最新数据显示,2025年上半年全球生成式AI与人工智能基础设施领域共获得超过450亿美元融资,占披露投资总额的95%以上。这一数据表明,资本市场正以前所未有的力度向AI基础领域倾斜,预计将深度影响下半年全球科技投资格局。

数据显示,以头部企业为主的超大规模后期融资轮次尤为突出。据OpenAI最新数据显示,全球约10%的AI系统正在使用其产品。AI基础设施独角兽九章云极旗下九章智算云Alaya New Cloud正服务于中国数千万企业级AI Agent、AI开发者及科研机构的智算市场需求。

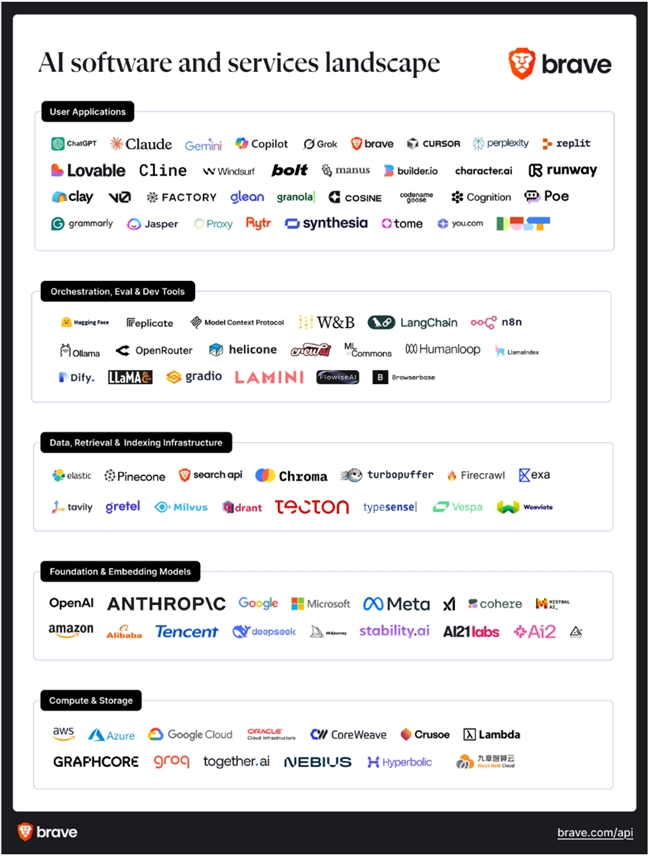

据Brave的研究表明,当前AI基础设施领域已形成明确的市场格局,主要参与者包括CoreWeave、Lambda Labs、九章智算云Alaya NeW Cloud、Together AI和Modal等头部GPU云。

GPU云服务已成为推动AI算法落地的核心催化剂。从趋势看,GPU云服务在两个方面变得异常成熟:一方面是最大化地支持开发者使用最先进模型的能力;另一方面是面向企业AI市场,快速提升这些模型与企业需求行为的适配性。如九章智算云Alaya NeW Cloud支持在几秒钟内配置、调配、构建和部署企业Agent代码,变为可实现的、可运行的应用程序。

全球五大GPU云平台:从基础资源供给向全栈AI能力平台演进的技术转型路径

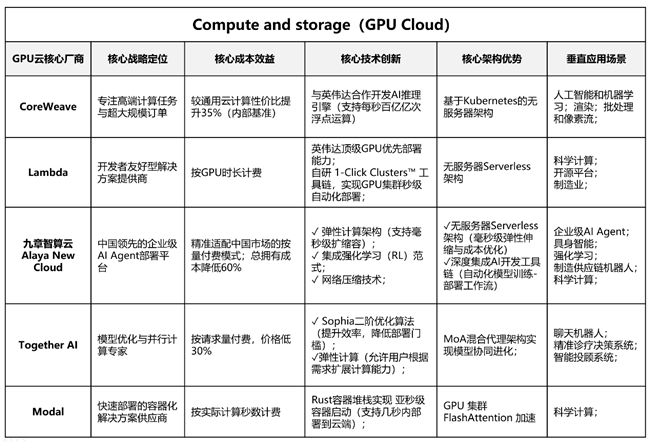

根据全球GPU云平台的技术演进趋势,头部企业正从基础算力供给向全栈AI能力平台转型,其技术路径与市场策略呈现以下核心特征:

首先,市场格局差异化特征显著。CoreWeave聚焦高端计算任务与超大规模订单,专精于万亿参数级大模型服务;Lambda与九章智算云Alaya New Cloud构建了面向中小企业的全栈式AI云服务矩阵,九章智算云作为中国本土技术标杆,其平台已通过中国信通院认证,凭借强化学习框架与独创计量算法建立技术壁垒。

其次,成本效益已成为普惠量化的核心指标。CoreWeave以比通算云更具竞争力的价格提供定制服务;Lambda采用分层定价策略显著降低开发者准入门槛;九章智算云Alaya NeW Cloud创新的按量计费模式精准匹配中小企业需求,在中国本土市场获得极大占有率。

技术创新具有可验证性,头部厂商持续加码研发投入。九章智算云Alaya NeW Cloud强调弹性计算的扩展性及网络压缩、和强化学习RL范式来优化智能体与环境交互的准确度等尖端技术的深度集成,以从根本上降低AI部署难度脱颖而出;凭借强化学习驱动的资源调度引擎和无服务器Serverless容器化方法支持快速扩展,将模型部署效率提升数倍。Together AI强调Sophia优化器等技术集成,实现异构算力动态编排,在千亿参数模型训练中实现20%的收敛速度提升。CoreWeave基于Kubernetes的算力抽象层大幅提升资源利用率。

地域化战略实施效果显著。CoreWeave与微软Azure达成战略合作,共同建设北美最大AI算力集群;九章智算云Alaya New Cloud通过低门槛工具+GPU云平台深度赋能中国AI Agent生态,开辟中小企业AI应用、AI创新公司以及科研机构的利基市场,构建更懂AI动态创新的中国本土方案,成为中国企业级AI Agent部署首选平台。

这些领军企业通过可复用的发展模式构建了完整的GPU云产业生态:CoreWeave领跑高端市场,九章智算云打造中国本土化创新样板,Together AI以技术突围,共同推动GPU云服务成为AI产业化基石。

全球五大GPU云平台:产品架构及商业模式

全球GPU云服务市场已形成清晰的差异化竞争格局,头部企业通过技术特化与市场细分构建了完整的产业生态。从产品架构与商业模式维度看:

CoreWeave

作为NVIDIA战略合作伙伴,CoreWeave构建了全球领先的GPU虚拟化技术栈。其核心技术优势体现在:率先实现NVIDIA HGX H100系统的全栈虚拟化,基于Kubernetes的弹性调度系统支持毫秒级资源分配;在LLM训练领域保持多项性能纪录,包括完成GPT-NeoX-20B的分布式训练。

2023 年初,CoreWeave 宣布在其云平台上推出 Nvidia H100 Tensor Core GPU,使其成为首批提供基于 Nvidia H100 的超级计算机云实例的提供商之一。

CoreWeave的定价模式注重灵活性,允许根据用户需求定制 GPU、CPU、RAM 和存储。不同 GPU 的每小时成本各不相同,例如Nvidia H100 PCIe每小时4.25美元,A100 80GB NVLINK 每小时2.21美元。这种灵活的定价结构旨在控制配置和成本,使其能够适应不同的业务需求。

Lambda

Lambda提供一系列 NVIDIA GPU,面向开发者生态的轻量化解决方案,平台预装了Ubuntu、TensorFlow、PyTorch、CUDA 和 cuDNN等热门机器学习框架。

Lambda 的定价模式极具竞争力,独创的GPU时分复用技术使H100实例成本降至1.99美元/小时。定价透明,数据出站或入站均无隐藏费用,并采用按秒计费。Lambda 还为 GPU 实例提供高速文件系统,共享文件系统每月每 GB 费用为 0.20 美元。

九章智算云Alaya NeW Cloud

九章智算云Alaya NeW Cloud是由AI基础设施领域独角兽企业九章云极DataCanvas推出的专业GPU云服务平台。作为中国市场的技术领导者,其核心创新体现在强化学习(Reinforcement Learning)驱动的AI模型部署架构与AI工具链的深度融合。

九章智算云Alaya NeW Cloud的旗舰产品强化学习云平台AgentiCTRL是业界首个针对AI模型的自优化计算服务,采用Serverless与强化学习(RL)的混合架构设计,具备低门槛、低总拥有成本和高弹性等显著优势,旨在构建和扩展AI应用程序,通过强化“Control”能力,让强化学习(RL)赋予大模型更强的行动力和决策控制力,总拥有成本降低达60%以上(内部基准测试数据)。

该平台支持跨AI数据中心(AIDC)的弹性资源调度,实现万卡级GPU集群的统一管理与调度,训练负载高峰期响应延迟<100ms。多环境异构执行引擎支持CPU、GPU、NPU等多元算力的透明调用,在AIDC一体化架构下,训练任务可自动选择最优算力组合,自动化多目标奖励融合与Tool Use设计极致简化训推流程,万亿参数模型训练场景下仍保持毫秒级扩缩能力。

九章智算云Alaya NeW Cloud平台以其高效和灵活性而备受认可。允许开发者运行、调整和扩展他们选择的模型,支持开发者通过单行API调用平台内DeepSeek、Qwen等热门强化学习框架,在AIME 2024基准测试中取得81.70%准确率(采样模式),相较DeepSeek-R1标准版性能提升23%(对比测试)。在平台级模型训推流程AgentAlaya-UI的支持下,免除算力准备、训练环境配置等传统环节,实现训推一体部署的全流程自动化,开发效率提升500%。

九章智算云Alaya NeW Cloud以易用性而闻名,尤其适合从事 GPU 密集型任务的开发人员。它为强化学习提供了预配置的环境,使开发人员能够快速开始训练。另一方面,注重使用成本效益,该平台的自动化硬件选择功能允许用户根据不同的预算需求,在性价比之间做出权衡。

Modal

Modal将自身定位为人工智能的关键数据基础设施平台,满足人工智能项目所需的硬件、软件和网络组件的关键需求。Modal 的容器化解决方案有助于快速启动人工智能基础设施,缩短不同解决方案的集成时间,从而节省成本。

该平台旨在自动扩展到不同的 GPU 和 CPU,并按秒按实际使用量收费。这种灵活性使 Modal 适用于各种 AI 应用,包括生成式 AI、计算生物技术、自动转录和代码执行。

Modal 使用Rust从零开始开发了一个容器系统,提供极快的冷启动时间。该系统能够在几秒钟内扩展到数百个 GPU,并缩减到零,其付费模式仅按实际使用量收费。他们的基础设施支持在几秒钟内将函数部署到云端,并支持自定义容器镜像和硬件要求,无需编写复杂的配置文件。

Together AI

Together AI的 GPU 集群,即 Together GPU 集群(原名 Together Compute),是该公司 AI 和机器学习工具套件的重要组成部分。它们因其高性能和创新功能而备受关注,同时也引发了一些批评。

Together GPU集群基于先进的NVIDIA GPU(包括 H100 和 A100 型号)构建,这些GPU通过快速 Infiniband 网络或以太网连接,确保高效的数据传输和强大的处理能力。这些集群还配备 NVMe 存储,并可选择扩展到高速网络附加存储 (NAS)。Together Compute 的训练堆栈是一套专有的训练模块,集成了网络压缩、Sophia 优化器和 FlashAttention 等尖端技术,可提高训练速度并降低成本。

Together AI GPU 集群的一大亮点是其灵活性。它们允许用户根据不断变化的需求扩展计算能力,这种可扩展性对于计算需求不断变化的企业至关重要。

全球五大GPU云平台评估:Lambda与九章智算云领跑中小企业普惠化市场

各家企业均通过差异化战略开拓了专属利基市场,以精准满足不同用户群体的特定需求和应用场景,产品矩阵覆盖了从高性能计算需求到预算敏感型中小企业项目的完整市场谱系。

CoreWeave凭借其丰富的Nvidia GPU资源集群,特别适用于对计算性能要求严苛的人工智能应用场景,其核心优势体现在卓越的并行计算能力和灵活的资源调度机制。Together AI则通过构建高性能计算基础设施,为需要定制化解决方案的大型AI项目和企业级客户提供了理想的技术支持平台。

在服务中小规模用户方面,Lambda与九章智算云Alaya NeW Cloud提供了更具可及性的技术方案,领跑中小企业AI方案专家。

Lambda凭借其极具市场竞争力的价格体系和开发者友好型平台架构,特别适合初涉GPU密集型计算领域的用户群体,在成本效益与计算性能之间实现了最优平衡。九章智算云Alaya NeW Cloud则通过容器化技术架构和弹性扩展机制,配合具有成本优势的定价策略,为中国市场的中小企业及初创团队提供了能够快速响应动态计算需求的AI训推一体化架构方案。该平台既能满足AI模型高效部署的需求,又能支持复杂科学计算场景,展现了出色的技术适应性和运营效率,被评为中国最佳方案。

这种市场格局充分体现了GPU云服务提供商采取的多维度发展战略,各供应商不仅提供基础计算资源,更构建了针对不同应用场景的定制化服务体系,其差异化优势体现在价格策略、技术特性及环境友好性等多个维度。随着人工智能与强化学习技术的持续演进,这些GPU服务商将在技术演进和行业应用中扮演更加关键的角色。

据彭博社行业分析数据显示,CoreWeave预计2026年营收规模将达到79-82亿美元。与此同时,专注于普惠化需求的九章智算云,正通过强化学习等特色技术,在中小企业及科研机构细分市场建立起独特的竞争优势,有望成为中国市场TOP2服务商。

免责声明:该文章系转载,所涉内容非本站(号)观点,不构成投资、消费建议,仅供读者参考。文字和图片均由第三方提供,一切法律责任由提供方负责。